Il y a quelques semaines, DeepSeek — un LLM made in China — a fait parler de lui, parce qu’il a été l’un des premiers à populariser l’usage du Chain of Thought : cette manière d’amener l’IA à raisonner pas à pas, à dérouler sa logique, comme si elle pensait à voix haute. D’autres modèles savaient déjà faire ça. Mais lui, il l’a mis sous les projecteurs.

Et voir l’IA dérouler sa “pensée” (attention, restons calmes, ces mots-là méritent des guillemets) — oui, il faut l’avouer, c’est impressionnant.

Et là, comme souvent dans ce genre de moment techno-messianique, on a eu droit au grand frisson collectif : “Oh là là, voilà que ça se rapproche de l’humain…”

Eh ben non. Raté.

Déjà, dans “chain of thought”, on lit surtout “chain”. Et c’est bien ça le problème. Une chaîne, c’est une suite logique. Ordonnée. Sécurisée. Dont la solidité tient à son maillon le plus faible. Et, comme toute chaîne, ça peut aussi enfermer.

Or l’humain n’est pas comme ça.

L’humain est un être fascinant. Il a cette capacité unique à écouter sans entendre. À hocher la tête en réunion pendant que son cerveau pense à la liste des courses. À répondre “oui” à une question qu’il n’a pas comprise. Présent physiquement, ailleurs mentalement.

Cette part de flottement fait partie du processus. Ce qu’on appelle “perdre le fil” est souvent le moment où quelque chose se recompose autrement. Le fameux singe des Simpsons, celui qui tape des cymbales dans la tête d’Homer, n’est pas si bête. Il maintient le rythme pendant que quelque chose de plus profond se prépare.

Appelons ça un dropout cognitif.

Ce moment où ça décroche, où ça flotte. Chez la machine c’est un bug, on corrige. Chez l’humain, on attend. On laisse le vide faire son travail. C’est une suspension. Et parfois, c’est là — précisément là — que la pensée commence à émerger. Ou pas. Car penser, pour un humain, c’est parfois moins que plus. Parfois même rien du tout. Et c’est très bien comme ça.

Quand l’humain apprend, ce n’est pas toujours net. Ce n’est pas droit. Il bifurque, il se perd, il trébuche, il revient. Une forme primitive — mais vivante — de backpropagation. Non pas codée, mais vécue. Il corrige, oui, mais en repassant par l’expérience. Non pas en optimisant un gradient dans un espace de paramètres, mais en tissant du sens.

Son raisonnement oscille entre deux pôles : parfois il part des faits pour en déduire d’autres (raisonnement prospectif), parfois il formule des hypothèses pour éclairer ce qu’il observe (raisonnement réflexif). Et souvent, il fait les deux à la fois, déduction/induction — car l’humain pense en spirale, pas en arbre binaire.

Ce n’est pas optimisé. C’est désordonné, incertain, vibrant. C’est incarné.

Chain of thought ? Non. Chaos of thought.

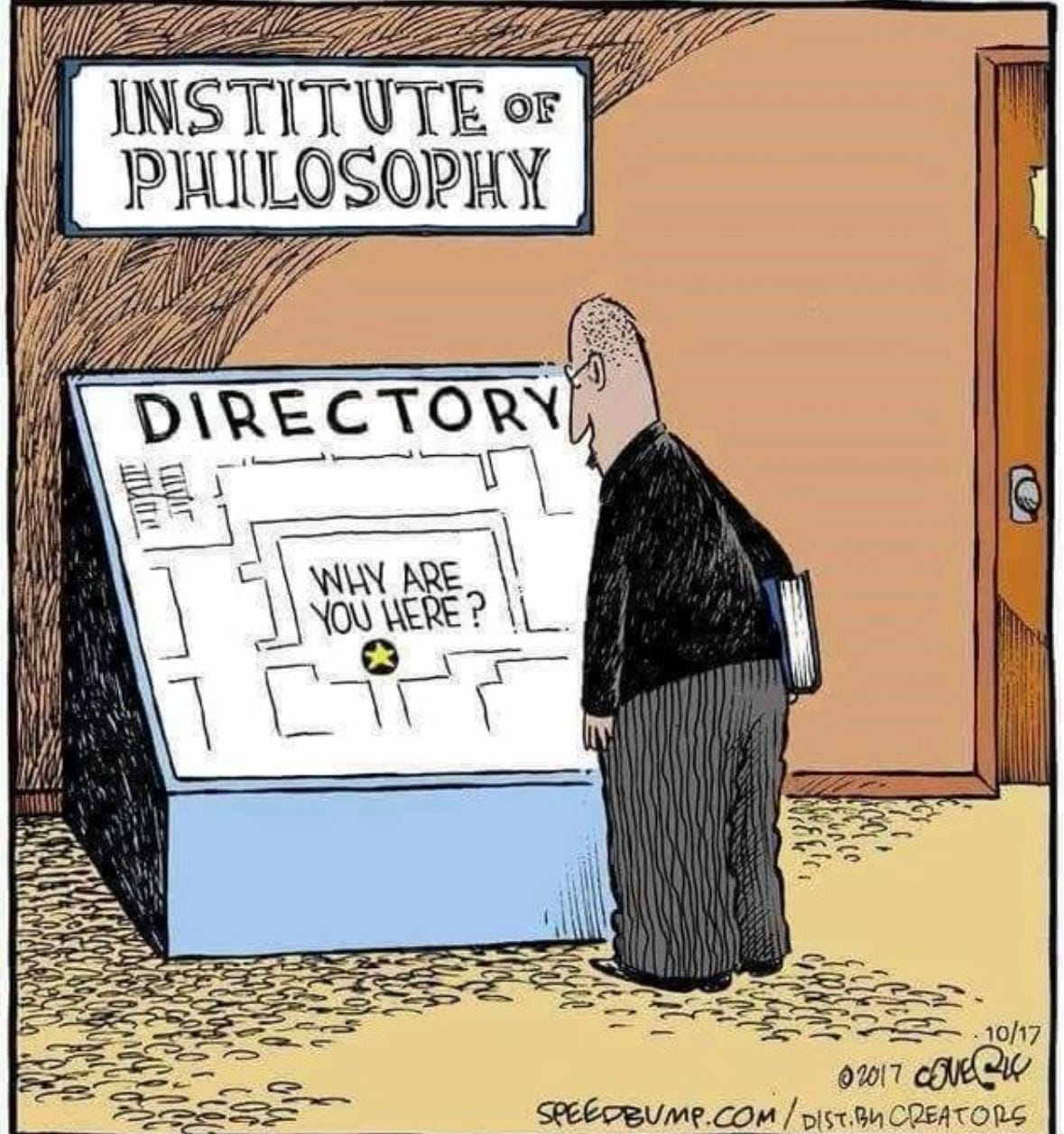

Ce cartoon dit beaucoup :

Le robot recalibre. L’humain décroche. L’un rétro-propage, l’autre digère.

Kurt Gödel l’avait senti venir : “Either mathematics is too big for the human mind, or the human mind is more than a machine.”

C’est ce qu’on appelle aujourd’hui le Gödellian Effect : ces moments où il ne suffit plus de calculer. Il faut sortir du cadre. Ré-imaginer. Faire un pas de côté (ou or cadre ;).

Une intelligence incarnée — pas modélisée.

Et parfois, ce pas-là ressemble à ça :

Tu viens chercher un repère, et on t’envoie une question. Et pourtant, ça fonctionne. Tu es à l’endroit exact où tu devais être.

Voilà ce que la machine ne sait pas faire. Elle ne sait pas pointer vers un vide qui ouvre. Elle ne sait pas ce que veut dire : “Pourquoi es-tu ici ?” – pas au sens spatial, mais existentiel.

Et c’est là qu’on revient à l’éléphant dans la pièce.

Parce qu’il y a des choses que la machine ne peut pas conceptualiser. Pas encore. Peut-être jamais. Des absences, des paradoxes, des connexions, des images idiotes qui font sens.

L’humain, lui, sent ça. Il voit ce qui manque. Il pressent ce qui déraille. Il invente là où il n’y a rien. Il comprend l’incongru, l’inutile, l’ambigu.

Et c’est peut-être là que tout se joue. Pas dans la puissance de traitement, mais dans la capacité à hacker le sens, à prendre le raisonnement à l’envers, à poser la mauvaise question au bon endroit.

Penser, ce n’est pas seulement raisonner. C’est continuer à inventer là où il n’y a pas de raison de le faire.

Comme disait Confucius : “quand tu es arrivé au sommet, continue à grimper”.

Alors oui.

On veut bien entraîner vos modèles.

Nourrir vos lignes de code.

Oui aux semaines de quatre jours.

Puisqu'ici tout est négociable,

Mais vous n’aurez pas —

Non, vous n’aurez pas —

Ma liberté de penser.

MD et JLA

Jean-Louis Amat travaille sur l'IA depuis 1984 (doctorat chez IBM), son parcours à la fois académique et industriel lui a donné une vision large et pratique du domaine, qu'il partage régulièrement.

---------

Pour ceux qui n’ont pas la réf ;) https://www.youtube.com/watch?v=RUOCC7z6gU0

La liberté de ne pas penser...

Illustration de la différence entre la pensée biologique et celle mécanique. Les deux se complètent.